Tricks for DeepSNN Learning

写在前面

这是可以说的吗🫣🫣🫣

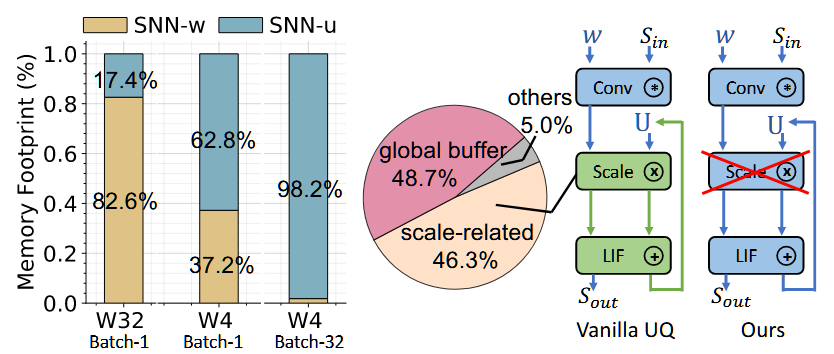

Efficient Training

调超参的时候可以先试试用Imagenet的100类试试,调的差不多了再上全部。

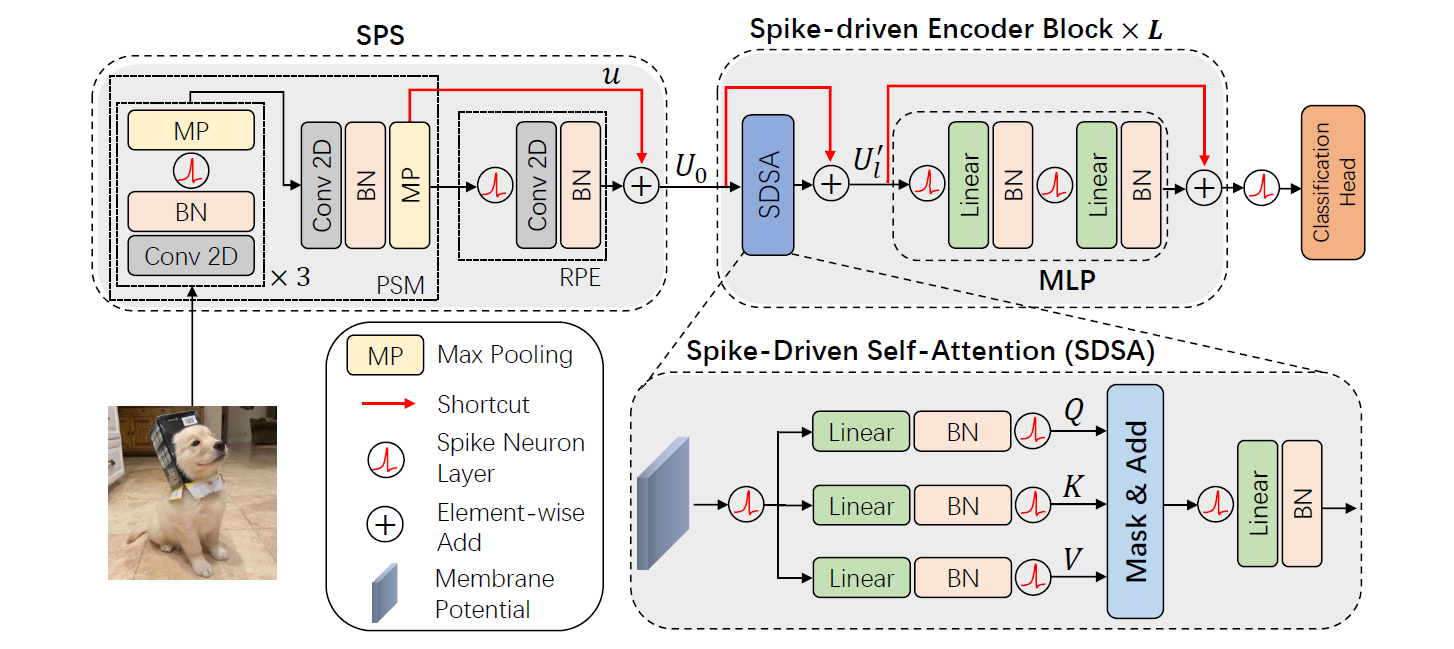

SNN Transformer Training

Transformer的常用Base lr是1e-4,adamw下是1e-4到6e-4之间,lamb可能需要再精调。adamw的前期收敛性太强了建议学习率linear warmup,用log怕炸

stdconv -> adaptive_clip clip_grad=0.02

正常的linear就torch自带的clip clip_grad=1 or 5

FasterViT?

Spike-driven Transformer V2/V3

检测与分割:除了backbone都是整数不norm

卷积算子貌似和整数(不带norm)很适配、attention貌似很和小数(带norm)适配

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Eric's Blog Site!